di Walter Quattrociocchi

Riportiamo qui altre riflessioni di Walter Quattrociocchi, professore ordinario di Informatica presso l’università di Roma “La Sapienza”, a proposito di intelligenza artificiale, Large Language Model (Chatgpt, Gemini ecc.) e illusione di conoscenza.

Il problema non è se i modelli “pensano” (non lo fanno). È come giudicano.

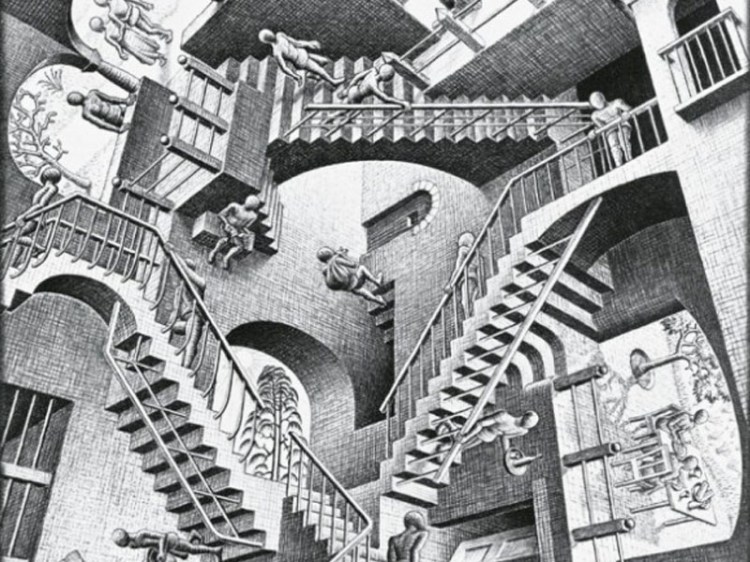

Da mesi il dibattito sull’intelligenza artificiale si incaglia sempre nello stesso vicolo cieco: coscienza, intenzionalità, mente estesa. Domande facili da evocare, ma affrontate a botte di pensiero circolare, (de)ragliamenti logici e finti paper su Nature che però non lo sono. Il risultato è pop-filosofia da aspiranti luminari con un tocco newage (i.e., molto fumo, poca analisi), ma con grossi problemi nella costruzione di argomenti.

Le cose sono mediamente più semplici e più concrete in realtà. Un LLM può arrivare alla stessa risposta di un essere umano, ma seguendo processi completamente diversi. E se cambia il processo, cambia il significato del risultato. Un dado truccato può darti sempre “sei”, ma non ha mai capito cosa significa vincere. Né possiamo dire che faccia abduzione per questo.

Gli LLM funzionano così, ormai lo sappiamo: producono testi coerenti non perché capiscono, ma perché ottimizzano correlazioni statistiche. Cercano solo la plausibilità linguistica. Ed ogni cosa che viene costruita sopra si porta dietro questo. Significa banalmente che per un LLM esiste solo il criterio linguistico (la forma). Quello epistemico (il senso) non c’è. Ed è qui che nasce e continua ostinatamente il vero problema.

Quando scambiamo coerenza per conoscenza, stiamo scambiando una simulazione per un giudizio fondato. Per decisioni si intende anche come impostare la chiave di lettura di un pezzo che ci facciamo sintetizzare e riassumere. Quando il genio (autoproclamato) e incompreso (ma che non ha molti strumenti) dice che si è fatto spiegare l’articolo da un LLM sta delegando ciecamente l’interpretazione. Si sente potenziato e redento dalla mediocrità, ma nella realtà s’è fatto mezzo e recipiente di un operato che porta e intesse tutto su pattern linguistici.

Per farla facile, la storia della mente estesa con gli LLM è bacata, perché se deleghiamo decisioni a un meccanismo che sembra ragionare come noi ma usa regole diverse e non operazionalizza l’affidabilità, costruiamo un’illusione di affidabilità che non regge alla prova dei fatti.

Non serve più chiedersi se i modelli “pensano”. Serve chiedersi:– quali criteri usano per giudicare?– quanto coincidono con quelli umani?– cosa accade quando divergono? La partita non è metafisica, è epistemica. Ripeto, la questione non riguarda la coscienza delle macchine, ma la nostra capacità di riconoscere quando un sistema funziona senza capire nulla.

***

Piccola riflessione a margine

Noto che si sta diffondendo un uso interessante degli LLM. Forse anche per colpa del marketing che li posiziona come abilitanti oltre la semplice produzione linguistica.

L’utilizzo degli stessi come interfaccia per i motori di ricerca è un forte indicatore del processo.

Che succede?

Quando non si capisce un testo, si chiede al modello di “spiegarlo”.

La spiegazione suona chiara e convincente, e questa chiarezza viene scambiata per comprensione. Ma non è affatto detto che l’output coincida con ciò che si pensa.

I modelli linguistici non capiscono ciò che producono.

Generano frasi plausibili dal punto di vista statistico, non significati costruiti.

Non verificano la coerenza, non tengono una visione d’insieme, non fanno inferenze sul mondo.

L’output sembra comprensione, ma non lo è.

In questo modo la fatica di capire viene vista come un problema ingiusto, e delegare diventa “liberazione”.

Peccato che, ignorando la natura degli LLM e, di conseguenza, dell’output, si perda di vista che ciò che si ottiene non è conoscenza.

Difficile poi vedere in questo processo inclusione, apprendimento o un atto di resistenza intellettuale.

Forse è più un modo per evitare il contatto con la realtà.

***

Comincia a emergere la vera pervasività dell’epistemia, quella condizione in cui la plausibilità sostituisce la verifica, e l’illusione di sapere prende il posto della conoscenza. Negli ultimi giorni sono emersi due casi emblematici: un giornalista che pubblica un articolo lasciando dentro la frase del prompt di ChatGPT e un report di Deloitte Australia, commissionato dal governo per quasi trecentomila dollari, con citazioni e riferimenti inventati da GPT-4. E non parliamo di studenti o hobbisti, ma di professionisti e consulenti. Segno che la deriva non è più marginale: è sistemica.

Quando uno vi dice che lui fa ricerca con ChatGpt in realtà sta dicendo che delega le sue lacune con un attrezzo che non sa come funziona. Abbiamo delegato il giudizio a un motore statistico del linguaggio, scambiando la coerenza di un testo per la verità di un contenuto. È questo il cuore dell’epistemia: la confusione tra consistenza linguistica e verità epistemica. Quando non hai competenze e ti illudi che un modello le possa colmare, non stai innovando: stai semplicemente rinunciando a capire.

Come sempre, la realtà è inesorabile. Le supercazzole reggono finché non incontrano un dato, un errore, un fatto che le frantuma […]: i modelli linguistici possono imitare il giudizio umano in superficie, ma seguendo logiche radicalmente diverse.Non è intelligenza. È la simulazione del giudizio. E la differenza, oggi, è tutto.Non dite che non lo sapevate.

l’AI contribuirà alla demolizione della coscienza critica.

"Mi piace""Mi piace"